Foto: Gorodenkoff/Shutterstock

Desde su presentación, el ChatGPT de OpenAI ha sido uno de los mayores acontecimientos del año. De repente, se teme que la Inteligencia Artificial (IA) haga innecesarios todos los trabajos. Pero a un juez estadounidense no le gusta el chatbot inteligente. De hecho, ChatGPT fue utilizado por un abogado en un juicio, pero eso le llevó a conclusiones erróneas.

ChatGPT proporciona información errónea

Así consta en los documentos publicados por CourtListener de un pleito entre la aerolínea colombiana Avianca Airlines y el demandante Robert Mata. Este último contrató al bufete de abogados neoyorquino Levidow, Levidow & Oberman para resolver en los tribunales un problema con la compañía colombiana.

No es ningún secreto que los pleitos llevan mucho tiempo y son difíciles, por lo que la IA puede, en principio, echar una mano ahí. Eso pensó Steven Schwartz, abogado de este bufete. Preguntó a ChatGPT por seis pleitos distintos similares al que nos ocupa, incluido el de «Varghese contra China South Airlines». Pero no parece que se tratara de un caso judicial real. Sin embargo, sí parece que se basaba en un caso que sí era real. Al parecer, el chatbot citó erróneamente los números del caso.

Pero esto no quedó ahí. Por ejemplo, incluso se habrían inventado declaraciones completas del juez, con citas inexistentes y citas inexistentes de detalles del caso judicial. No está claro si ChatGPT inventó estos detalles por sí mismo o los obtuvo de fuentes no especificadas.

En el documento, Schwartz dice que lamenta la decisión de utilizar ChatGPT. Poco sabía él que el modelo de IA a veces puede ser erróneo.

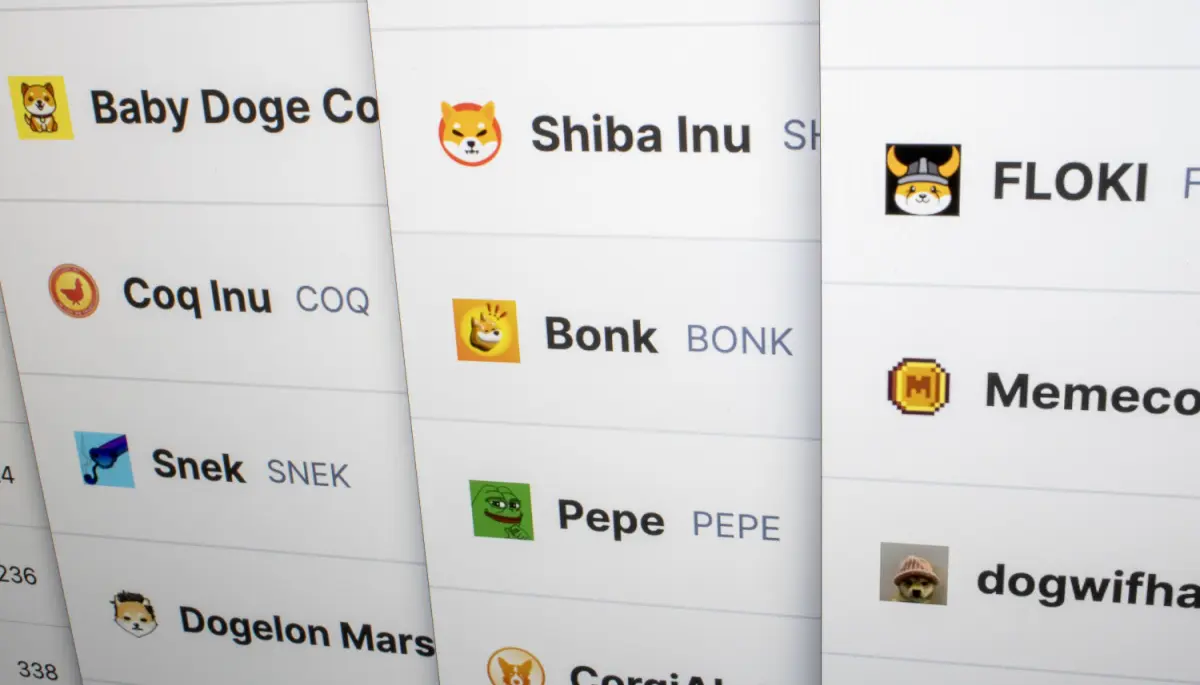

La frontera entre la IA y las criptomonedas es cada vez más difusa

Aun así, los avances en Inteligencia Artificial van muy deprisa. Mientras tanto, la IA y el blockchain están incluso empezando a fusionarse. Por ejemplo, puedes preguntar a ChatGPT sobre la información en tiempo real procedente de Solana (SOL). El CEO de Circle también cree que los bots de IA ya actúan de forma independiente en USDC.

Aun así, hay quienes no están tan contentos con los avances. Por ejemplo, un destacado investigador de IA y antiguo empleado de Google cree que la tecnología es muy peligrosa. Incluso el CEO de OpenAI, Sam Altman, ha advertido al gobierno estadounidense de los riesgos.

A juzgar por esta situación judicial, podemos suponer que nuestros señores artificiales aún no están preparados para dominar el mundo. Así que podemos estar tranquilos durante un tiempo.